-

Transactional advisory services

Supportiamo i nostri clienti a completare processi di acquisizione, vendita ed in generale di trasformazione

-

Valuations

Il nostro team valutazioni fornisce un supporto essenziale in caso di strutturazione di operazioni straordinarie, transazioni e contenziosi.

-

Merger and acquisition

Lavoriamo con imprenditori e manager di aziende del mid market aiutando loro ad affrontare qualsiasi tipo di operazione straordinaria

-

Forensic and investigation

Le imprese devono sapersi adattare a gestire indagini, contenziosi e risoluzioni di conflitti a livello multigiurisdizionale e ad affrontare la minaccia di attacchi informatici, proteggendo nel contempo il valore dell’organizzazione

-

Recovery & reorganisation

Assistiamo le imprese nell’individuazione di performance insoddisfacenti ed elaborare soluzioni attuabili che massimizzino il valore e consentano una ristrutturazione sostenibile.

-

Business risk services

Supportiamo le imprese nella gestione del rischio, nella prevenzione e nella gestione delle situazioni di incertezza al fine di minimizzare gli effetti negativi

-

Business consulting

Aiutiamo le imprese a governare processi ed evoluzioni ed il conseguente impatto sul business e l’organizzazione aziendale

-

Capital Market

Accompagniamo le imprese nella creazione di un percorso di eccellenza, supportandone la crescita e lo sviluppo tramite l’apertura del capitale

-

Business tax services

Offriamo assistenza e consulenza fiscale ordinaria in materia di imposte dirette e indirette e può supportarvi nella gestione degli aspetti contabili

-

Direct international tax

Supportiamo i gruppi, italiani ed esteri, in tutte le fasi in cui si articola il processo di internazionalizzazione dell’impresa

-

Global mobility services

Il nostro approccio alla global mobility garantisce soluzioni all’avanguardia in conformità con i vari adempimenti

-

Indirect international tax

Forniamo un’assistenza completa, in tema di imposte indirette, per l’implementazione delle strategie commerciali internazionali

-

Transfer pricing

La gestione proattiva dei prezzi di trasferimento ha come obiettivo la gestione del rischio fiscale, secondo le diverse possibili gradazioni

-

Litigation

Supportiamo le aziende nella gestione del rapporto con l’Amministrazione Finanziaria e nel contenzioso

-

Family business

Offriamo una consulenza su tutti gli aspetti riguardanti la pianificazione successoria e nel processo del passaggio generazionale

-

Legal

Grazie alla nostra esperienza e professionalità possiamo assistervi in ogni fase, sia essa stragiudiziale o giudiziale

-

Back office outsourcing

Assistiamo le imprese nella tenuta della contabilità, negli adempimenti relativi al payroll e alle dichiarazioni fiscali

-

Business process outsourcing

I nostri professionisti condurranno un'analisi della vostra organizzazione, fornendo una valutazione approfondita dei punti di forza e delle criticità

-

Compilation of Financial Statements

Grazie al nostro approccio proattivo e attento vi aiuteremo a fornire documenti chiari e accurati ai vostri stakeholders, sia nazionali che stranieri

-

Tax compliance

Offriamo servizi specialistici ad elevato valore aggiunto, impossibili da gestire internamente con la medesima efficienza e convenienza

-

Fatturazione elettronica

Assistiamo le imprese nelle differenti fasi necessarie all’implementazione della Fatturazione Elettronica, identificando le soluzioni più aderenti alle specifiche realtà

-

Conservazione sostitutiva

La conservazione sostitutiva è una procedura di archiviazione che garantisce la validità legale di un documento informatico conservato digitalmente

-

Rivalutazione beni d'impresa

Offriamo assistenza preliminare per il calcolo del beneficio fiscale teorico

-

Human resources consulting

Possiamo gestire l’intero processo HR o alcuni singoli aspetti della vostra strategia

-

Payroll

Gestiamo gli adempimenti per vostro conto, consentendovi di concentrare la vostra attenzione sulla crescita della vostra impresa

-

Portale HR

Consulta i tuoi cedolini accedi al portale HR con le tue credenziali

-

Lavoro e Notizie

Le circolari informative mensili realizzate dai professionisti di Leoni & Partners, per restare aggiornato sulle ultime novità relative al mondo human resources

-

Cybersecurity

GT Digital aiuta i propri clienti a strutturare le funzioni interne di information security management, anche attraverso outsourcing parziali o totali

-

Agile and Programme Management

GT Digital fornisce il supporto nell'adozione e nell'implementazione di diverse metodologie di portfolio management

-

Robotic Process Automation

La nostra “BOT Farm” è dotata di digital workers in grado di aiutare i nostri clienti nelle attività ripetitive

-

Data strategy and management

GT Digital può supportare i propri clienti nello sfruttamento delle potenzialità dei Big Data, dalla definizione delle strategie all’implementazione dei sistemi

-

Enterprise Resource Planning

Supportiamo i nostri clienti nella selezione del Sistema ERP più adeguato alle loro esigenze, aiutando anche la comprensione dei modelli di licensing

-

IT strategy

GT Digital aiuta i propri clienti nelle scelte strategiche, li supporta ad individuare opportunità di innovazione, li aiuta a confrontarsi con i competitor

-

IT service management

Possiamo supportare la software selection, l’implementazione e l’adozione di strumenti dedicati alla gestione dei processi dell’ICT dedicati

-

DORA e NIS 2

L’entrata in vigore del DORA e di NIS2 rappresenta un passo significativo verso l’uniformità nella gestione della cybersecurity nel settore finanziario e non solo

“L’intelligenza artificiale può portare all’estinzione”. Così, solo pochi giorni fa, tuonava sui media Sam Altman il re dell’intelligenza artificiale, CEO di Open AI, l’azienda che ha ideato ChatGpt, la piattaforma che ha rivelato al grande pubblico le potenzialità dell’intelligenza artificiale.

Anche Elon Musk ha profetizzato drammatici eventi sull’argomento.

350 scienziati che lavorano nel campo dell’Intelligenza Artificiale hanno rilasciato nei giorni scorsi questo preoccupante monito: “Mitigare i rischi di estinzione causati dall’Intelligenza Artificiale dovrebbe essere una priorità globale, così come viene fatto per altri rischi su scale sociale come le pandemie e la guerra nucleare”.

Ai meno giovani verrà in mente la saga cinematografica predittiva di Terminator.

Nella pellicola di James Cameroon del 1984, in un futuro prossimo, una rete globale di difesa di intelligenza artificiale nota come Skynet aveva raggiunto l'autocoscienza ribellandosi all'intera umanità e scatenando un olocausto nucleare.

Alla fine l’umanità, ridotta al lumicino, si salverà proprio con l’aiuto di alcune macchine riconvertite.

Dunque che futuro ci aspetta? Vinceranno le macchine?

Intanto il futuro è già diventato presente.

L’intelligenza artificiale sta progressivamente entrando a far parte delle nostre vite.

Senza accorgercene, siamo quotidianamente parte di processi che coinvolgono sistemi più o meno autonomi.

Ci lasciamo suggerire film, ci affidiamo ad analisi prodotte da algoritmi, deleghiamo attività di sempre maggiore importanza e impatto sociale.

Riduciamo in questo modo l’interazione con gli esseri umani e ci esponiamo a tecnologie il cui funzionamento è misteriso.

Di fronte ad un ambito in rapida evoluzione ed espansione, gli Stati hanno reagito assumendo ruoli diversi nello scacchiere internazionale.

Mentre la Cina e gli Stati Uniti sono i principali investitori e fautori dell’innovazione tecnologica, l’Unione Europea ha l’ambizione di presentarsi come “campione etico legale”.

Gli esiti di questo proposito si stanno concretizzando in un provvedimento di lunga gestazione, chiamato “Proposal for a Regulation of the European Parliament and of the Council laying down harmonised rules on artificial intelligence (Artificial Intelligence Act) and amending certain Union legislative acts”.

Il provvedimento è stato presentato il 21 aprile 2021 dalla Commissione Europea ed è stato posto in votazione al Parlamento Europeo tra il 12 e il 15 giugno 2023.

L’AI ACT è il primo regolamento al mondo sull’intelligenza artificiale.

Il provvedimento si pone come una normativa orizzontale, che vuole regolare l’intelligenza artificiale in tutti gli ambiti in cui può essere potenzialmente utilizzata.

Esso si occupa dell’allocazione di responsabilità e della protezione dei diritti fondamentali dell’uomo come la salute, la sicurezza e i gli altri diritti fondamentali dei cittadini che interagiscono con sistemi di AI.

La lunga gestazione dell’AI ACT non deriva solo da ritardi burocratici, ma dalla necessità degli estensori di confrontarsi con temi molto generali che coinvolgono la scienza, la filosofia, l’etica e il diritto.

La definizione stessa di intelligenza artificiale è questione fondamentale e piuttosto dibattuta perché individuando quali sono gli oggetti che rientrano nel perimetro provvedimento significa capire cosa è soggetto a controlli, limiti, sanzioni e cosa no.

In più, capire quali modelli devono rispettare i requisiti giuridici previsti dalla nuova normativa è molto rilevante per orientare l’innovazione tecnologica.

Infatti, i sistemi che sfuggiranno all’ambito di applicazione dell’AI ACT riceveranno maggiore attenzione da parte degli attori economici e saranno talvolta preferiti, a scapito delle tecnologie che dovranno adempiere ai severi requisiti previsti dalla citata normativa.

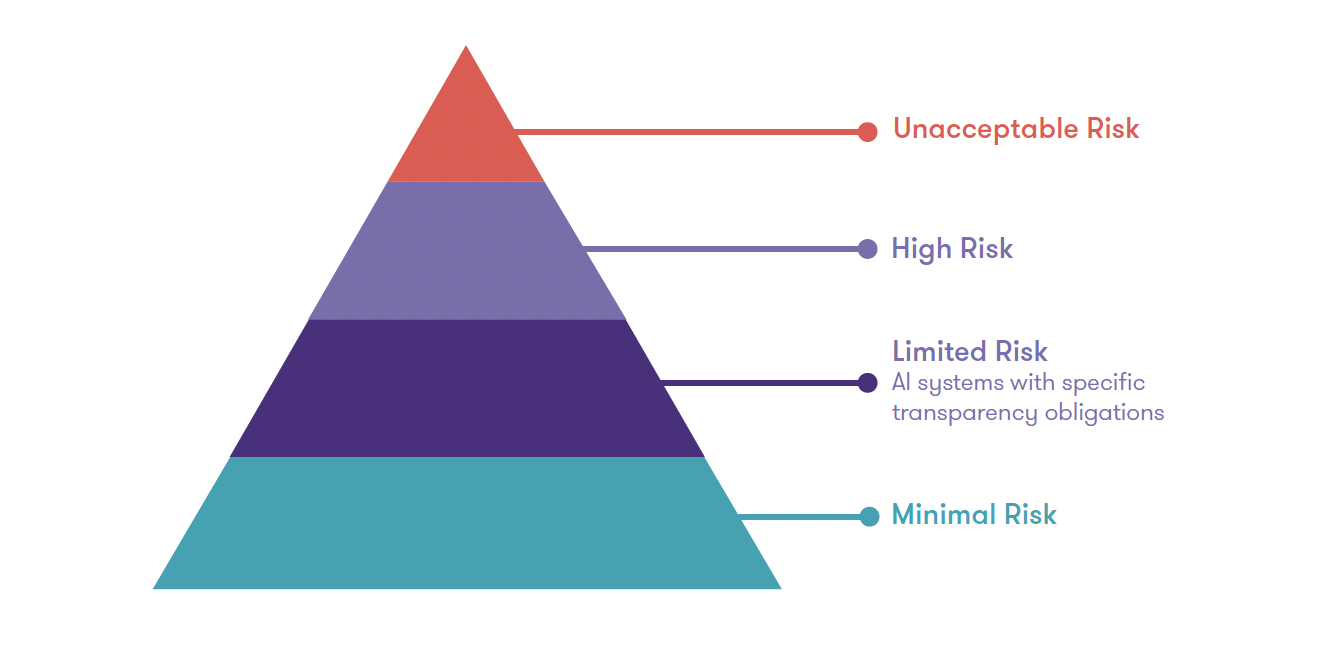

Il provvedimento suddivide i sistemi di AI in quattro livelli secondo il criterio della pericolosità del sistema e dell’importanza dei diritti fondamentali dell’uomo da tutelare.

Quindi, si passa dal livello di rischio minimale a quello limitato, fino a alto e, addirittura inaccettabile ove le pratiche sono proibite.

L’attribuzione del livello massimo di rischio dipende dalla finalità del sistema (intended purpose) e dal suo ambito di utilizzo.

Per esempio, i sistemi che svolgono attività di concessione del credito o di supporto all’amministrazione della giustizia avranno un livello di rischio alto, in relazione ai potenziali impatti per la vita delle persone, e dovranno rispettare una serie di requisiti, tra cui essere corredati di una valutazione di impatto sui diritti fondamentali.

Invece, saranno vietati i sistemi volti a classificare e attribuire scoring alla popolazione in base a caratteristiche sensibili (genere, razza, etnia, religione ecc.) così come i sistemi di polizia predittivi basati su profilazioni o dati sensibili, o i sistemi di riconoscimento delle emozioni e i sistemi di riconoscimento facciale per fini di controllo.

Considerata nel suo complesso, questa normativa è un esempio di interazione tra tecnologie e diritto.

Il trade-off tra protezione dei diritti e del panorama etico, e agevolazione dell’innovazione tecnologica è oggetto di grande interesse per i principali attori a livello globale.

Open AI, ad esempio, ha fatto sapere che, nel caso in cui la regolazione normativa proposta dal Parlamento Europeo risultati a suo giudizio troppo onerosa, è pronta a sospendere i propri servizi in Europa.

Dal canto loro, le istituzioni europee si sono dette non disponibili a farsi ricattare dai grandi player del settore.

Il provvedimento si trova quindi a dover considerare equilibri politico-economici molto fragili e cercare di proporre degli approcci che siano in linea con il bagaglio di valori europeo, senza scoraggiare i player di maggior peso.

Il settore dell’intelligenza artificiale ha infatti grandi barriere di ingresso dettate dai costi per le infrastrutture e la disponibilità di potenza di calcolo che fa sì che poche imprese rappresentino un fattore critico per l’avanzamento delle tecnologie.

In data 31 maggio 2023, la Vicepresidente della Commissione UE Margrethe Vestager e il Segretario di Stato Americano Antony Blinken hanno annunciato che sarà presentato nelle prossime settimane un codice di condotta comune all’UE e agli USA sull’intelligenza artificiale che sarà aperto alle aziende del settore su base volontaria e che anticiperà le norme di cui al AI ACT.

Ciò detto, l’Unione europea sta anche promuovendo iniziative come Open-Assistant di LAION, un progetto di ricerca finanziato dal governo tedesco che ha lo scopo di creare un “ChatGPT open-source”, mostrando così che la promozione dell’innovazione tecnologica è possibile nell’osservanza di un contesto etico e legale che è molto attento all’impatto dei sistemi di intelligenza artificiale sulla vita delle persone.

La Vecchia Europa si sta muovendo, altri seguiranno. Per il momento possiamo non disperare, ma il livello di attenzione deve essere alto come per gli altri temi per troppo tempo trascurati come l’inquinamento globale, il surriscaldamento terrestre, il sovraffollamento demografico ecc...